0 引言

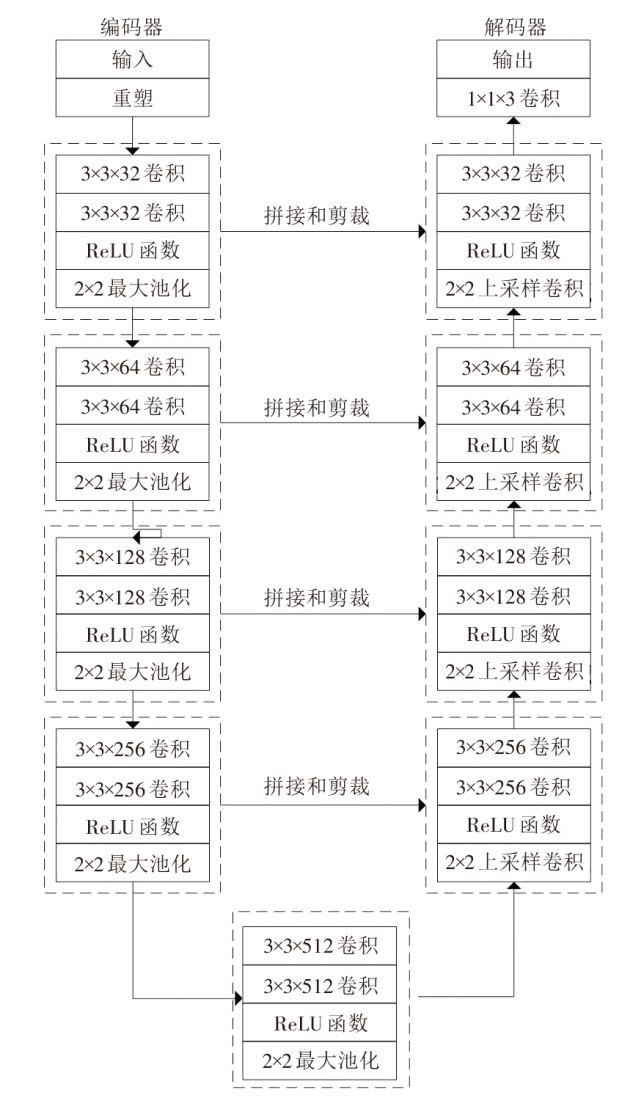

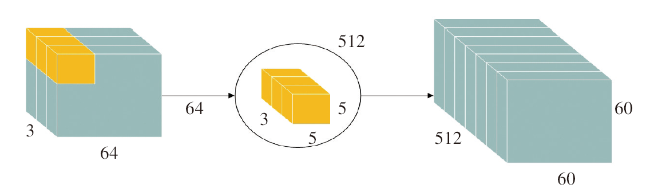

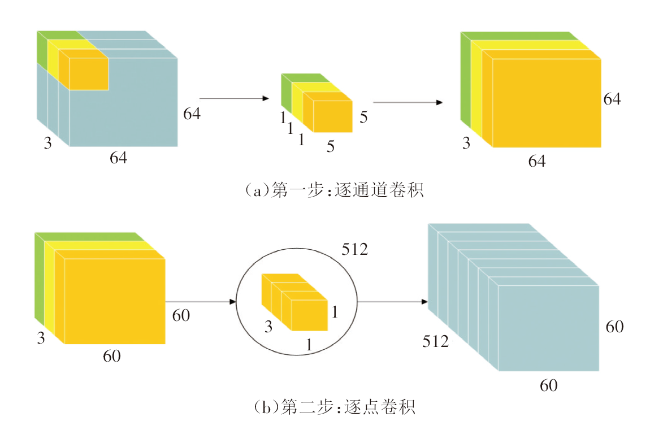

1 车道线和检测区的语义分割算法

1.1 U-Net网络结构的特点

1.2 深度可分离卷积结构

表1 标准卷积与深度可分离卷积的对比 |

| 卷积类型 | 参数量 | 运算量 | 比例 |

|---|---|---|---|

| 标准卷积 | Dk×Dk×M×N | Dk×Dk×M×N×Dw×Dh | 1 |

| 深度可 分离卷积 | Dk×Dk×M+ M×N | Dk×Dk×M×N×Dw×Dh+ M×N×Dw×Dh | 1/N+ 1/Dk2 |

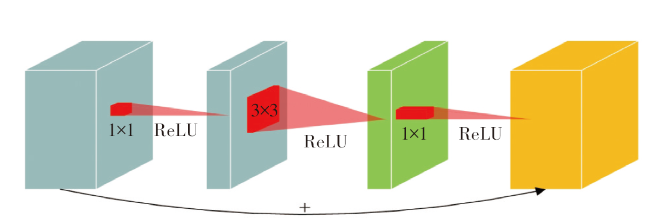

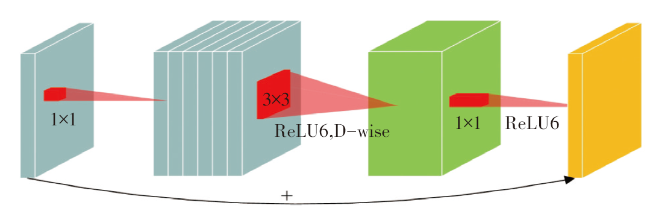

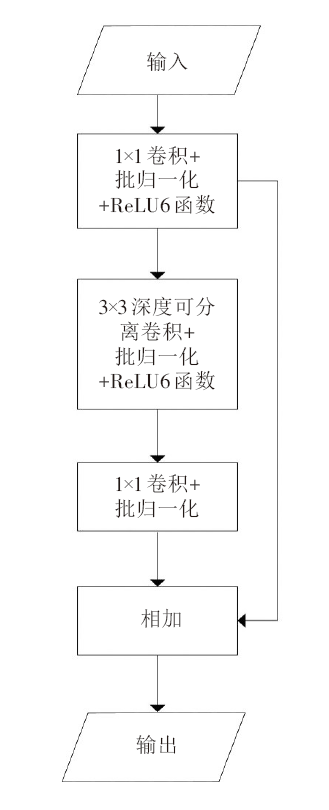

1.3 倒置残差结构

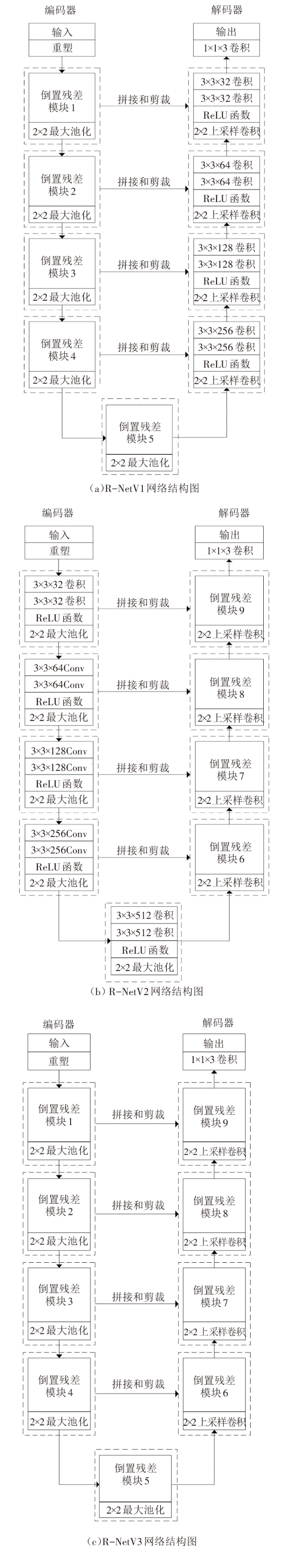

1.4 轻量化网络模型设计

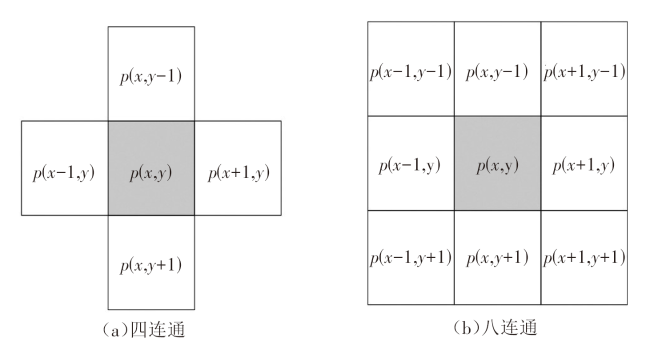

2 基于连通域分析的车道线和检测区标记算法

3 车道线和检测区的语义分割实验

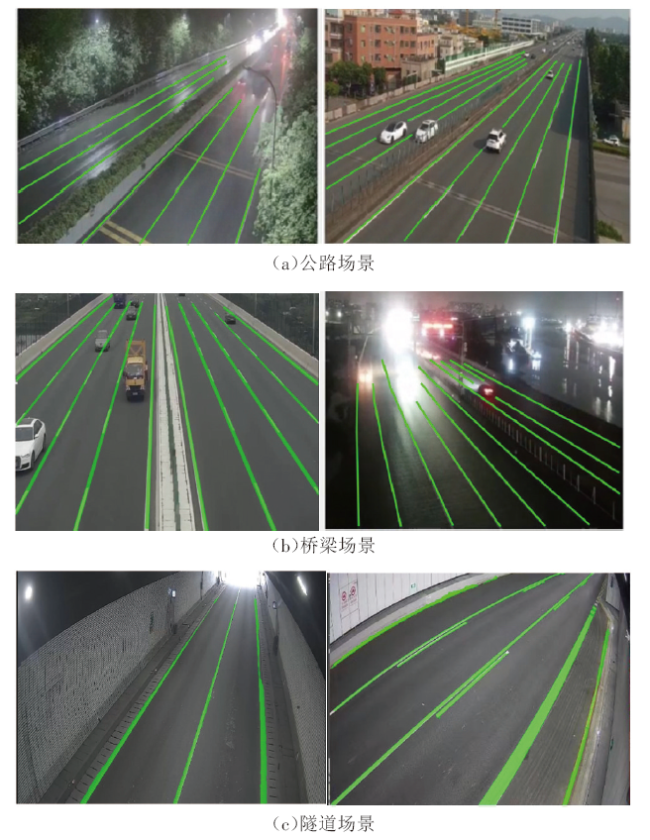

3.1 实验数据集

3.2 实验设置

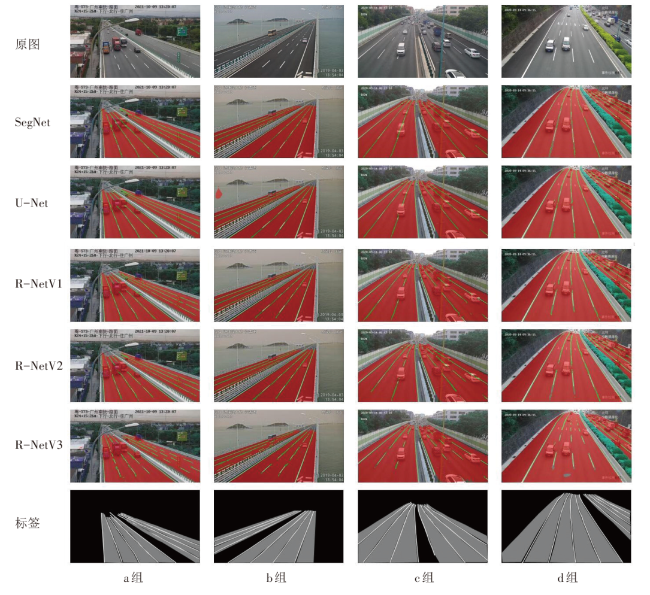

3.3 实验结果分析

表3 各模型的实验结果对比 |

| 模型 | IoU(%) | MIoU (%) | 模型参数量/MB | 内积运算 量/GB | ||

|---|---|---|---|---|---|---|

| 车道线 | 检测区 | 背景 | ||||

| SegNet | 68.3 | 95.4 | 94.9 | 94.1 | 28.08 | 502.03 |

| U-Net | 58.3 | 91.8 | 92.7 | 91.0 | 7.76 | 174.88 |

| R-NetV1 | 54.7 | 89.8 | 91.5 | 89.3 | 3.76 | 129.56 |

| R-NetV2 | 52.5 | 91.5 | 92.5 | 90.6 | 4.76 | 65.63 |

| R-NetV3 | 39.7 | 88.0 | 90.5 | 87.6 | 1.03 | 20.30 |

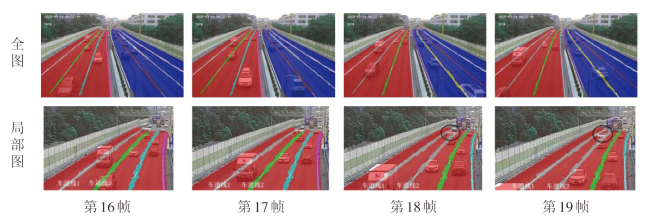

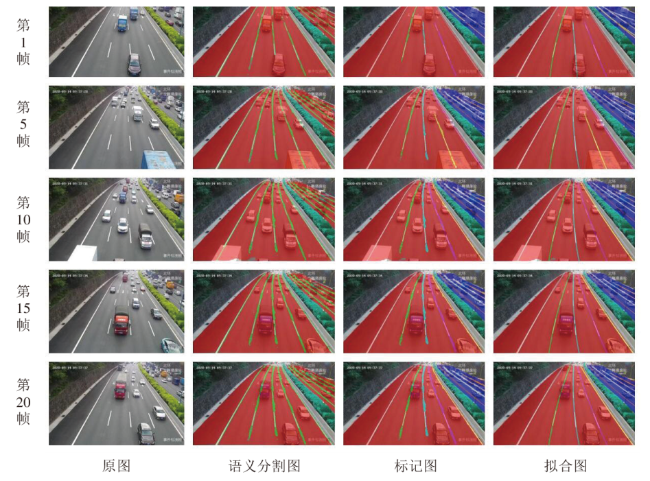

4 车道线和检测区的标记实验

4.1 实验模型和数据集

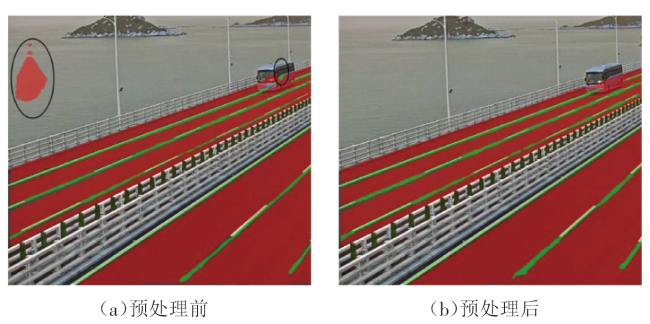

4.2 标记前的预处理方法

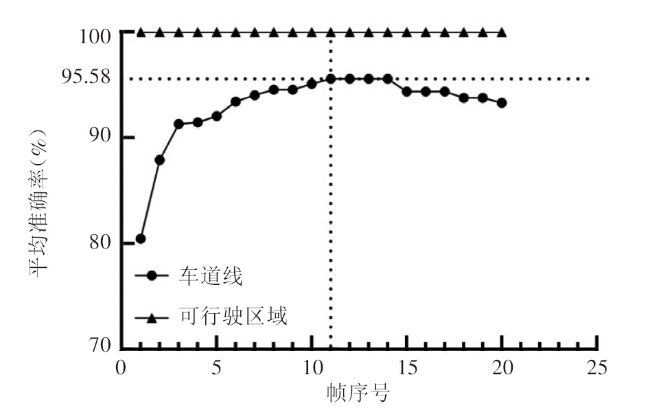

4.3 实验结果分析

表4 第1帧~第10帧的平均准确率 |

| 帧序号 | 平均准确率(%) | |||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | |||||||||||||

| 检测区 | 100 | 100 | 100 | 100 | 100 | 100 | 100 | 100 | 100 | 100 | ||||||||||||

| 车道线 | 80.47 | 87.91 | 91.31 | 91.46 | 92.05 | 93.44 | 94.04 | 94.57 | 94.57 | 95.10 | ||||||||||||

| 帧序号 | 平均准确率(%) | |||||||||||||||||||||

| 11 | 12 | 13 | 14 | 15 | 16 | 17 | 18 | 19 | 20 | |||||||||||||

| 检测区 | 100 | 100 | 100 | 100 | 100 | 100 | 100 | 100 | 100 | 100 | ||||||||||||

| 车道线 | 95.58 | 95.58 | 95.58 | 95.58 | 94.39 | 94.39 | 94.39 | 93.79 | 93.79 | 93.32 | ||||||||||||