目前许多研究者基于这一目标进行了深入研究。主要的几类解决方案可概括为:基于专家数据的模仿学习类方法、基于模型的强化学习方法、基于约束马尔可夫决策的安全强化学习方法以及安全校验类方法。基于专家数据的模仿学习类方法需在训练阶段提供专家的驾驶轨迹数据,以有监督的方式模仿专家的驾驶行为,可以快速掌握较好的驾驶能力。如,Kuefler等

[2]结合生成对抗学习的思想,提出了具有代表性的生成对抗模仿学习(GAIL)算法;连天宇

[3]尝试将模仿学习与强化学习相结合,以提升强化学习的安全性和效率。这类方法一般不涉及显式的安全约束。第二类解决方案是基于模型的强化学习方法,如杜凌宇

[4]利用数据学习系统的近似模型,再利用模型进行控制规划,并结合模型预测控制(Model Predicted Control, MPC)求解带安全约束的规划问题。这种方法需要全面的数据来构建模型,较依赖模型的精准程度。在有关安全强化学习的研究中,一种典型的范式是将问题建模为带约束的马尔可夫决策过程,基于拉格朗日法或李雅普诺夫法在含有约束的情况下进行优化训练,如Yu等

[5]提出的基于可达性约束的强化学习方法。此类方法具有很好的理论基础,但需针对不同的问题和场景进行复杂的理论分析和约束条件设置。安全校验类方法主要通过向强化学习的决策结果添加额外的安全校验和约束来保证安全性。该方法又可细分为三类,第一类为多策略融合方法,将强化学习策略与具有安全约束的策略结合,通过策略切换保证安全性,具有代表性的成果有杨威

[6]提出的拟人化驾驶决策方法。第二类为高层决策加低层安全约束方法,其相对更具整体性,以张智飞

[7]提出的强化学习结合软约束MPC的方法以及刘延东

[8]提出的基于动态最小安全距离约束的强化学习变道超车框架为代表。这类方法在规划控制层面尽可能地避免危险,没有对高层决策直接的安全监督。第三类直接对高层决策行为进行安全校验和约束,如代珊珊等

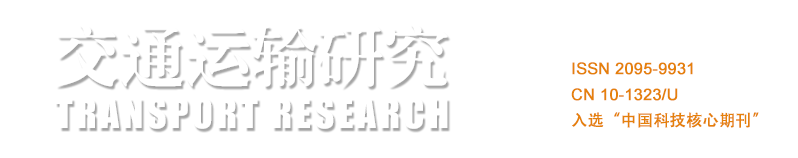

[9]提出基于强化学习和动作约束的安全自动驾驶方法,研究了车道保持问题,当判断出不安全的约束动作时放弃执行操作;Wang等

[10]提出了一种基于深度Q网络(Deep Q Network, DQN)算法的、添加了安全规则约束的决策方法来研究横向车道变换问题,而在纵向速度控制时采用常用的规则控制;Chen等

[11]针对多智能体强化学习模型下的高速公路匝道合并问题,提出一种考虑加速、减速、保持车速和车道、向左换道、向右换道共5种决策动作的安全约束方法,该方法基于最大安全间隔筛选最优的安全动作,可能会表现得过于保守。